MIDI / audio : deux manières de concevoir la musique, deux systèmes à la fois proches et différents qui depuis quelques années cohabitent au sein d’un même logiciel. Historique, explication et mise en pratique...

Pour beaucoup de monde, encore et bien souvent des débutants, la notion de MIDI ou d’audio est assez abstraite. Ce qui n’est guère étonnant car si l’on vous parle de diesel ou d’essence pour une voiture, vous connaissez le nom, vous en connaissez la mise en pratique (vous l’utilisez au quotidien) mais vous ne savez pas réellement comment cela fonctionne et quelle est la grande différence (hormis de faire plus de kilomètres avec un plein de diesel).

La plupart des questions qui reviennent concernent ces deux mots : MIDI et audio, indissociables du monde de la M.A.O. et pour quiconque, qui n’a pas « grandi » dedans et suivi l’évolution, cela peut paraître incompréhensible de prime abord. Un petit historique s’impose donc.

La révolution du MIDI

Au début des années 80, le paysage technologique musical est en pleine mutation. Peu à peu, sous l’effet d’artistes comme Vangelis, JM Jarre, Kraftwerk ou Tangerine Dream, les synthétiseurs analogiques ont envahi les productions et les studios et, les constructeurs du moment se mettent à fabriquer en série des générations de machines désormais cultes, c’est l’époque des Roland SH-101, des Korg Polysix ou des Moog Prodigy. Mais toutes ces machines ne pouvaient « dialoguer » entre elles ou alors, au prix de terribles bidouillages, souvent hasardeux.

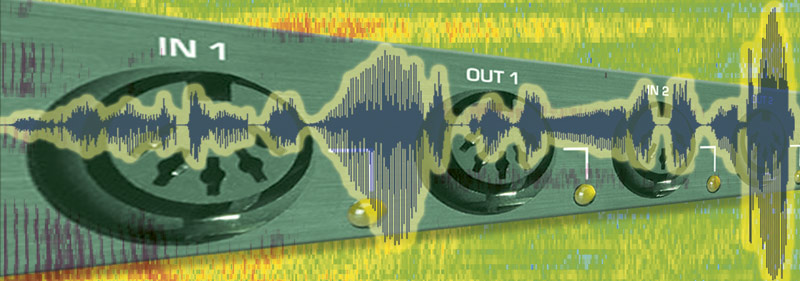

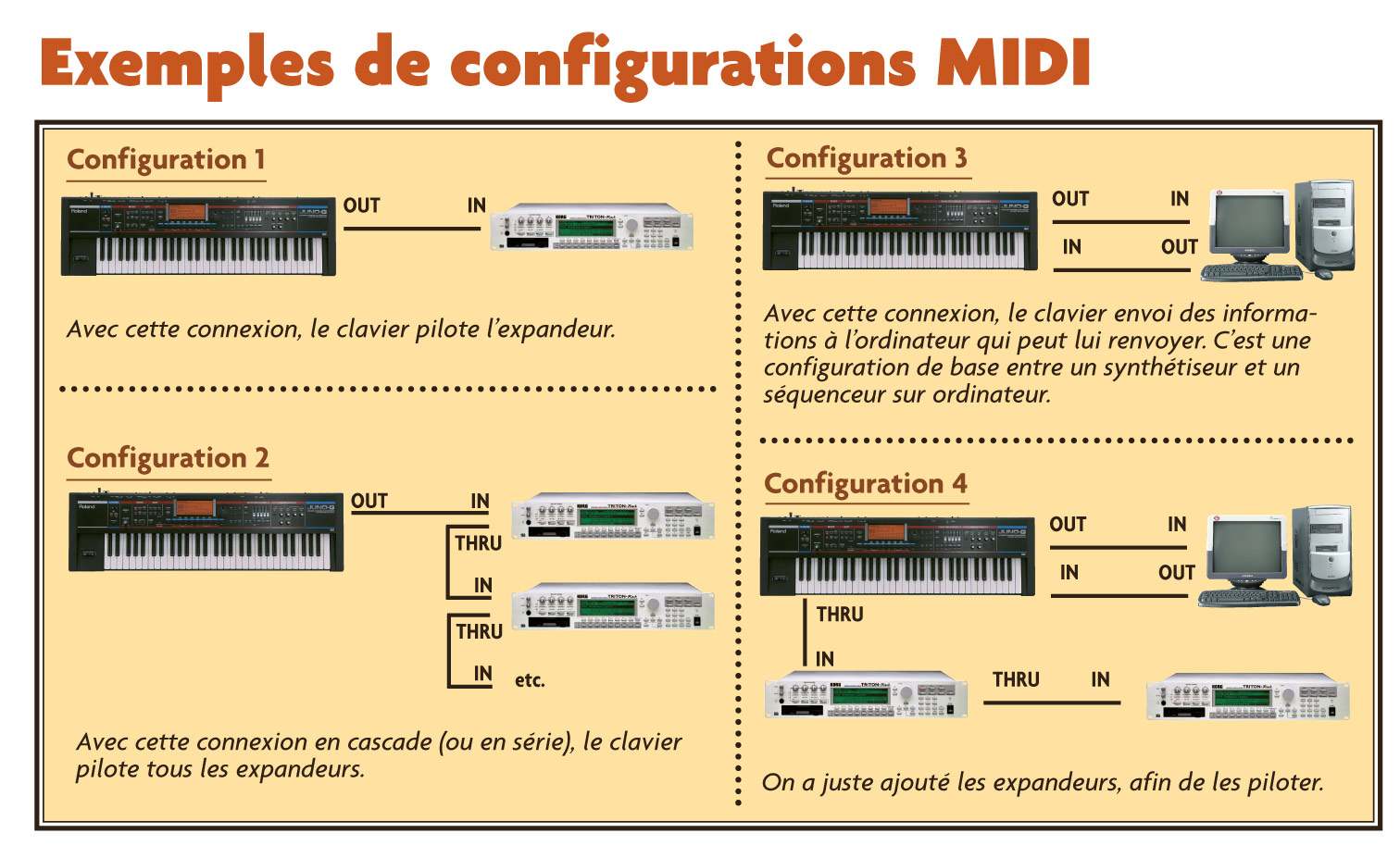

C’est alors qu’apparue en 1983, la norme MIDI (Musical Instrument Digital Interface) permettant ainsi aux différents appareils (synthétiseurs, expandeurs, boîtes à rythmes...) de communiquer ensemble. Pour une fois, ce standard fut adopté par tout le monde et à l’heure actuelle, nous l’employons toujours. Pour l’utilisateur lambda, le MIDI se présente sous deux aspects. Le premier est une forme physique en la présence de prises (ou ports) que l’on retrouve sur les appareils : In, Out et Thru. Cette interface joue le rôle d’un émetteur/ récepteur dès lors qu’on la câble avec un autre appareil.

Ce qui nous conduit au deuxième aspect du MIDI : le langage. En effet, ces prises MIDI servent à faire transiter un langage informatique. La MIDI Out envoie des informations, tandis que la MIDI In réceptionne les informations. Ainsi, pour piloter un expandeur (synthétiseur en rack, c’est-à-dire sans clavier), on branchera toujours le port MIDI Out du clavier vers le port MIDI In de l’expandeur.

De ce fait, les informations émises par le clavier comme la molette de Pitch Bend, la vélocité des touches (et/ou l’aftertouch) ou un bouton de LFO, piloteront l’expandeur. Vous pouvez visualiser cette configuration (config. 1) dans le schéma ci-dessous : La troisième prise (MIDI Thru) permet de relier plusieurs appareils entre eux (voir config.2). En fait, c’est une deuxième sortie MIDI qui se borne à faire simplement transiter le signal reçu par le MIDI In de la machine.

La troisième prise (MIDI Thru) permet de relier plusieurs appareils entre eux (voir config.2). En fait, c’est une deuxième sortie MIDI qui se borne à faire simplement transiter le signal reçu par le MIDI In de la machine.

Le langage MIDI

Comme expliqué un peu plus haut, les prises MIDI servent à véhiculer les informations entres les appareils. Ces informations sont de toutes sortes : volume, panoramique, note enfoncée ou relâchée, changement de programme d’une sonorité, etc. Mais le plus important, c’est qu’elles circulent par canaux. En effet, la norme MIDI prévoit 16 canaux. On peut ainsi piloter 16 machines monotimbrales ou une machine multitimbrale ou encore plusieurs sonorités par machine, puisqu’il est (heureusement) possible de déterminer à chaque fois le canal d’émission des sons au sein des appareils.

Mais que se passe-t-il lorsqu’on a plus de 16 canaux ? Eh bien, il suffit d’acheter une interface MIDI avec plusieurs MIDI Out et grimper ainsi, sans problème, jusqu’à 512 canaux MIDI (ce qui, il faut bien l’admettre, est largement suffisant). Notez qu’il vous faudra également posséder un séquenceur capable de gérer au-delà de 16 canaux MIDI, ce qu’ils font quasiment tous maintenant. Mais plus il y a de machines et plus les risques de problèmes augmentent. Par exemple, si vous chaînez trop de machines les unes aux autres (comme dans notre config. 2), avec notamment des longueurs de câble MIDI importantes, vous risquez d’obtenir un phénomène de latence (retard) sur vos dernières machines, d’où parfois un léger décalage sur des séquences musicales. D’autant que certains vieux synthés «vintages» ont une tendance à accentuer ce phénomène (ce qui est le cas par exemple pour le Roland D-550 qu’il est préférable de mettre au début d’une chaîne MIDI).

Toutefois, il est facile de contourner ce problème sur un séquenceur car la plupart propose de régler sur chaque piste un délai MIDI. Ainsi, avec un réglage approprié, vous pouvez envoyer des informations plus tôt, afin que votre machine anticipe son retard et joue dans le rythme. En détournant cette utilisation du retard MIDI dans le séquenceur, vous pouvez dupliquer une piste, en gardant le même canal MIDI (donc le même son) et sur cette nouvelle piste, utiliser un retard de quelques millisecondes, provoquant ainsi un effet de Delay ! Dupliquer autant de fois que vous voudrez, en jouant aussi, pourquoi pas, sur la vélocité (avec un volume descendant peu à peu).

Et l'USB fit son apparition

Avec l’arrivée de l’ordinateur au sein du home-studio, la création musicale a bénéficié des dernières technologies dont l’USB ! Désormais, les interfaces MIDI se connectent à l’ordinateur via ce protocole ou mieux encore, les claviers intègrent une prise USB et se relient directement à l’ordinateur : plus besoin d’interface ! C’est le cas des claviers maîtres dont les plus petits disposent d’une alimentation externe, le port USB fournissant l’énergie nécessaire.

Comme nous l’avons vu précédemment, le MIDI est un langage de communication entre des machines équipées d’une interface MIDI (prises In, Out, Thru). Mais l’audio ? Vaste sujet. Commençons donc par définir ce qu’est un « son ».

Définition du son

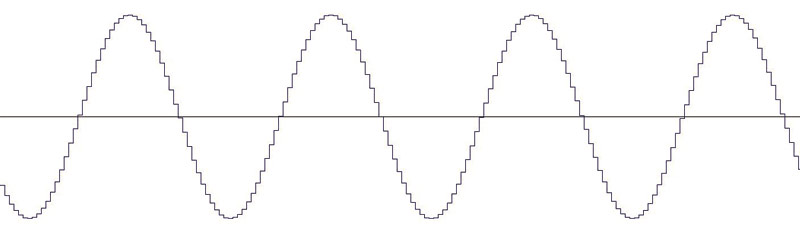

Pour faire simple : le son est une vibration de l'air. Ainsi, pour émettre un son, on peut faire vibrer un objet. Par exemple, pour un piano, c’est le marteau qui frappe la corde ou bien pour une guitare, le pincement sur la corde qui procure la vibration (amplifiée par une caisse de résonance). Cette vibration peut être reproduite graphiquement par une courbe sonore :

Quel est donc le rapport avec l’audio que nous utilisons avec nos ordinateurs et nos échantillonneurs ? Simplement que cette courbe (donc un signal sonore analogique) va être numérisée au moyen d’une interface audio (échantillonneur hardware – ou sampleur –, logiciel audio sur un ordinateur équipé d’une carte son, etc.). La numérisation consiste à transformer un signal analogique en signal numérique.

Quel est donc le rapport avec l’audio que nous utilisons avec nos ordinateurs et nos échantillonneurs ? Simplement que cette courbe (donc un signal sonore analogique) va être numérisée au moyen d’une interface audio (échantillonneur hardware – ou sampleur –, logiciel audio sur un ordinateur équipé d’une carte son, etc.). La numérisation consiste à transformer un signal analogique en signal numérique.

Autrement dit, à découper par intervalles réguliers la forme d’onde. On obtient ainsi une série de points numériques qui redessinent la courbe. Deux paramètres déterminent cette conversion analogique/numérique : le nombre de mesures par seconde, appelé taux (ou fréquence) d’échantillonnage et la résolution, c’est-à-dire la précision de mesure de l’amplitude de la courbe (exprimé en bits). Ainsi, à titre d’exemple, un CD audio traditionnel est à 44,1 kHz sur 16 bits (soit 44 100 échantillons pour une seconde de son enregistré).

Partant de ce principe, plus la fréquence et la résolution d’échantillonnage sont élevées et plus la qualité d’enregistrement est meilleure, à condition également de posséder de bons convertisseurs ana- logique/numérique sur votre machine.

Dans la pratique

Un fichier audio est donc une forme d’onde numérisée. Ce fichier peut être de taille réduite,quelques kilo-octects, à plusieurs giga-octets. Tout dépend bien sûr de votre capacité de stockage et de l’utilisation que vous voulez en faire.

Que vous sauvegardiez ou que vous chargiez un fichier audio, vous vous confrontez au problème du format. Il y a quelques années de cela, les échantillonneurs hardware possédaient leur propre format de sauvegarde/lecture des samples. Ainsi, on se retrouvait avec des échantillons Akai, E-Mu, Ensoniq, Roland, Kurzweil, etc. Avec l’arrivée de l’ordinateur au sein du home-studio et l’évolution des systèmes des sampleurs, certains formats comme le .WAV (issu des PC) se sont démocratisé.

De même, les dernières générations de sampleurs permettaient de lire des formats concurrents. Ainsi, avec un Kurzweil K2000 ou K2500 vous pouviez accéder à la banque de sons de chez Akai, Ensoniq, Roland et bien sûr, lire les fichiers .WAV.

De nos jours, ce sont les échantillonneurs virtuels, sous forme de plug-ins ou en version stand-alone, qui propo- sent leurs propres formats et la lecture d’autres samples, tels que Steinberg HALion, Tascam GigaStudio, Propellerhead NN-XT, E-Mu Emulator X, Apple EXS24... Mais il existe aussi de petits programmes permettant de convertir les formats, comme CDXtract pour PC et Macintosh. Un soft fort pratique qui, pour moins de 100 €, permet de convertir aux formats suivants : Akai, Roland, E-MU, SoundFont, Giga, SampleCell, Kurzweil, Kontakt, Wav, Aiff, SD2, ReCycle, etc.

Des sons par milliers

Cette compatibilité alliée aux gigantesques banques de sons produites ces dernières années sur CD, et maintenant sur DVD, offre désormais au musicien un large choix en matière de palette sonore. Il y en a pour tout le monde : des sons de flûtes indiennes en passant par les tambours de la fanfare de la ville de Boustifloc-Plage.

Disponibles soit en version déjà samplée (il n’y a qu’à charger le son dans l’échantillonneur), soit en version audio (il faut échantillonner soi-même), les banques de sons sont devenues au fil du temps un élément incontournable du musicien, au même titre que les disquettes de sons pour les synthétiseurs dans les années 80/90.

Une des particularités fort prisée du sampling est de pouvoir utiliser des sons se rapprochant le plus possible d’instruments acoustiques. Ainsi, on a vu fleurir des banques de sons de piano, guitare, cordes, cuivre, etc, au réalisme saisissant. Certes, pour obtenir un son de piano de qualité, cela demande beaucoup de mémoire afin de lire les nombreux fichiers de sample associés.

La boucle est bouclée

Lorsque l’on parle de sample, on englobe toutes les sonorités, y compris les boucles, c’est-à-dire des séquences d’un ou plusieurs sons, répétées indéfiniment. Ainsi, on peut accéder à des parties rythmique ou de basse ou de guitare permettant de construire un morceau facilement et rapidement. Mais, car il y a toujours un mais, nous étions, jusqu’à ces dernière années, limités par le tempo de la boucle. Ainsi, si votre partie rythmique était samplée à un tempo de 140 bpm et que votre morceau était à 120 bpm, cela posait problème.

Les premiers logiciels d’édition audio (donc de sample) ont commencé à intégrer des fonction de Time Stretching, c’est-à-dire de pouvoir étendre ou compresser temporellement un échantillon sans en altérer sa hauteur de son. Il est ainsi possible de «caler» une boucle sur un tempo déterminé.

Certes, toutes ces opérations étaient fastidieuses et longues, puis apparurent sur le marché des logiciels comme ACID de Sony ou GarageBand de chez Apple (puis par extension sur les Logic Pro et Express), des séquenceurs de boucles offrant la possibilité de mixer des boucles entre elles avec la particularité de se recaler aussitôt sur le bon tempo. Un pas de plus était franchi.

Pour conclure

Après le MIDI, la deuxième grosse révolution dans le musique électronique demeure l’audio qui occupe désormais une place indétrônable dans le home-studio, pour très longtemps encore.

Dossier réalisé par Ludovic Gombert en février 2006 (M•A•O• Magazine)